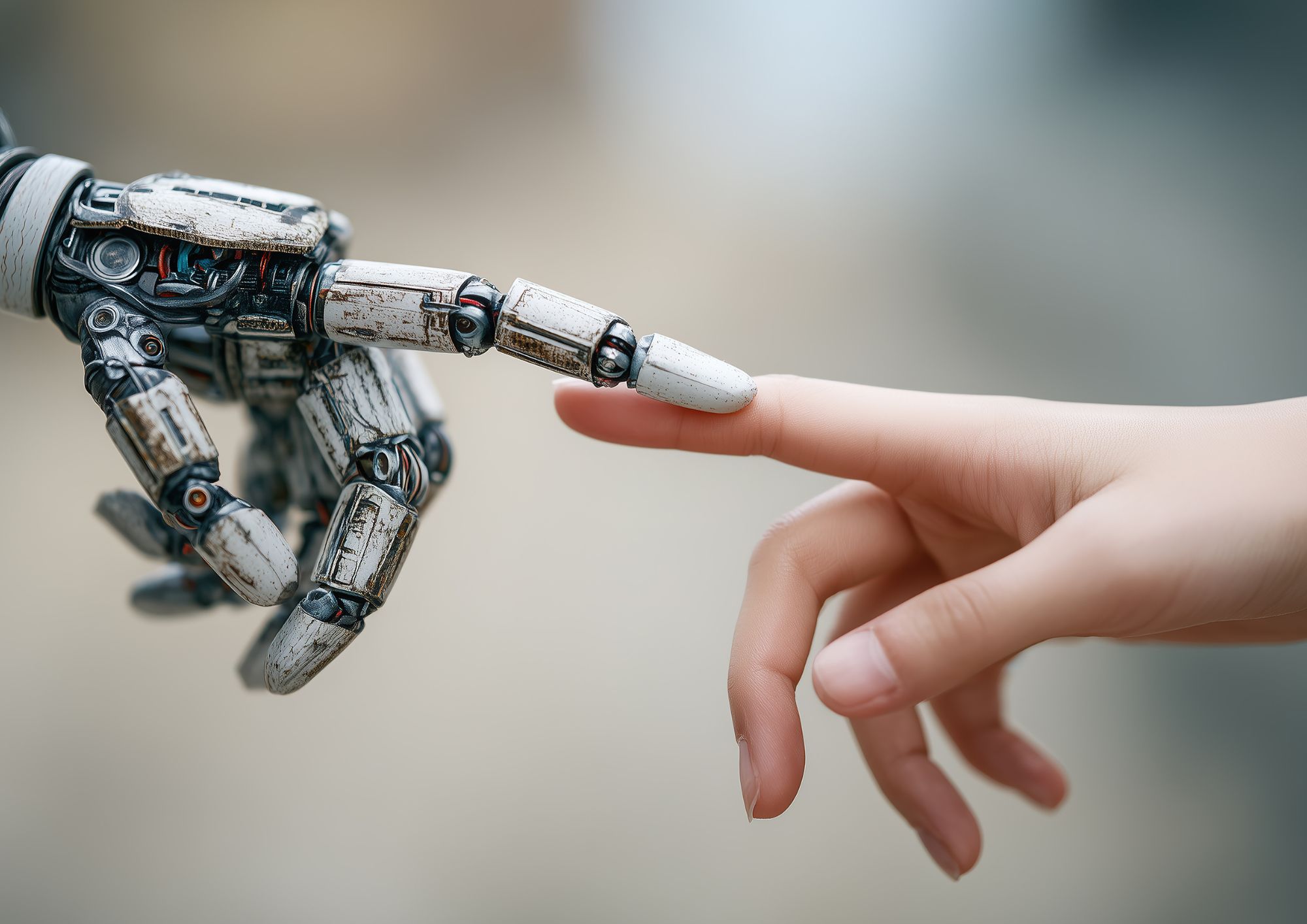

Negli ultimi anni l’intelligenza artificiale ha compiuto passi da gigante non solo nel riconoscimento di immagini e nel linguaggio naturale, ma anche nella capacità di interpretare segnali emotivi umani. Quello che un tempo era solo immaginazione fantascientifica — una macchina che possa “capire come ci sentiamo” — è diventato un campo concreto di ricerca e sviluppo noto come Emotion AI o IA empatica.

Ma che cosa significa davvero una “intelligenza artificiale empatica”? E quali sono le implicazioni pratiche di tecnologie in grado di leggere emozioni, adattare comportamenti e interagire con gli esseri umani su un piano apparentemente affettivo?

Cos’è l’Emotion AI e come funziona

L’idea di dotare le macchine della capacità di riconoscere emozioni non è nuova. Negli anni Novanta, la ricercatrice del MIT Rosalind Picard pose le basi del cosiddetto affective computing, settore che incrocia informatica, psicologia e scienze cognitive con l’obiettivo di sviluppare sistemi capaci di rilevare, interpretare e rispondere agli stati emotivi umani.

Oggi i sistemi di IA empatica analizzano dati provenienti da:

- Espressioni facciali

- Tono e inflessioni della voce

- Linguaggio del corpo

- Testi scritti

Questi input vengono elaborati da algoritmi di machine learning addestrati su grandi dataset, associando pattern specifici a emozioni come felicità, rabbia o tristezza.

Tecnologie avanzate integrate anche in progetti di ricerca combinano segnali fisiologici, come quelli misurati da EEG o sensori biometrici, con analisi facciale e vocale per stimare lo stato emotivo in tempo reale, dando vita a “agenti conversazionali empatici” capaci di risposte più naturali.

Dove si usa e dove si potrebbe usare

Le applicazioni dell’IA empatica sono già sperimentate in diversi settori:

- Sanità e benessere mentale: strumenti di supporto per facilitare conversazioni emotive, ad esempio in assistenza psicologica online, possono aiutare operatori umani a comprendere segnali di disagio.

- Customer service: chatbot capaci di adattare le risposte in base al tono percepito di un cliente frustrato possono migliorare l’esperienza dell’utente.

- Sicurezza stradale: sistemi che monitorano affaticamento o distrazione dei conducenti analizzando posture e movimenti oculari segnalano potenziali pericoli.

- Intrattenimento e assistenza personale: robot sociali come Furhat simulano interazioni faccia‑a‑faccia, aprendo nuove prospettive nei rapporti tra umani e macchine.

Empatia artificiale: simulazione o “sentire”?

Una delle questioni più dibattute riguarda se l’IA possa veramente comprendere le emozioni o le limiti soltanto a imitarle. Gli esperti concordano sul fatto che, nonostante i progressi, le macchine non possiedono coscienza né esperienza emotiva soggettiva: possono calcolare e prevedere stati affettivi, ma non provano sentimenti nel senso umano del termine.

In altre parole, l’IA può simulare empatia — rispondendo in modo adeguato a segnali emotivi — ma questa resta una risposta calcolata, priva di esperienza interna. Questo solleva quesiti profondi: fino a che punto possiamo affidare relazioni emotive o supporto psicologico a entità che non “sentono”?

Regole, privacy e limiti normativi

Proprio perché l’IA empatica analizza dati altamente sensibili — espressioni facciali, voce, testi — la normativa comunitaria si è mossa per tutelare privacy e diritti degli utenti. Dal 2 febbraio 2025 è entrato in vigore il AI Act europeo, che classifica come “ad alto rischio” e vieta alcune applicazioni di riconoscimento delle emozioni in contesti lavorativi o scolastici non medici, per prevenire discriminazioni o abusi.

Questo significa che oggi non è consentito impiegare IA per dedurre le emozioni di un candidato durante un colloquio o monitorare gli studenti in classe, se non in casi legati alla sicurezza o alla salute.

I rischi e le sfide etiche

L’IA empatica porta con sé rischi concreti:

- Privacy: l’elaborazione di dati emotivi richiede consenso esplicito e robusti sistemi di protezione.

- Interpretazioni errate: emozioni e segnali possono variare con la cultura, l’esperienza personale e il contesto, con il rischio di giudizi sbagliati o stereotipati.

- Manipolazione: sistemi emotivi potrebbero essere usati per influenzare scelte di consumo o comportamento, oltre che a sfruttare vulnerabilità psicologiche.

Oltre alla regolamentazione, servono anche trasparenza nei modelli, supervisione umana e trasmissione ai cittadini di conoscenza critica su ciò che queste tecnologie possono — e non possono — fare.

Il futuro dell’IA che “sente”

Guardando avanti, gli sviluppi dell’IA empatica non si fermeranno. L’integrazione di segnali neurofisiologici e l’impiego di modelli avanzati di apprendimento potrebbero rendere le interazioni uomo‑macchina sempre più “umane” nella forma. Ma mentre progredisce la tecnologia, resta centrale la domanda etica e sociale: come vogliamo che questi strumenti entrino nelle nostre vite, e con quali garanzie per la dignità e la libertà emotiva delle persone?